-

Azure OpenAI Service

Azure OpenAI Service

自社のAI Copilot作成を支援するAzure AI Studio

「Azure AI Studio」という新機能がMicrosoftの開発者向けイベントである「Bui […] -

Azure OpenAI Service

Azure OpenAI Service

ChatGPTを使ったUI/UXデザインの効率化

UX/UIデザインの世界では、利用者の体験を向上させるアプローチが常に求められています。その中で、近 […] -

Power BI

Power BI

Power BIと連携力:Microsoftの優位性がもたらすBIの革新

Microsoftは、Gartner®社が発表している「Analytics and Business […] -

Azure OpenAI Service

Azure OpenAI Service

会議の効率を向上させるChatGPT:議事録とToDoリスト自動生成の活用

会議の効率化はビジネスにおいて重要な課題の一つですが、議事録作成やToDoリストの生成など、従来の手 […] -

Azure OpenAI Service

Azure OpenAI Service

ソーシャルメディアマネジメント:ChatGPTでコンテンツ戦略を立てる方法

ソーシャルメディアが急速に発展し、企業や個人のビジネス戦略にも不可欠なものとなりました。しかし、その […] -

Azure OpenAI Service

Azure OpenAI Service

ChatGPT活用:実践的プロンプト付きプログラミング学習

プログラミングは今や多くの人が学ぶべき重要なスキルとなっていますが、初心者にとってはなかなか難しいも […] -

Azure OpenAI Service

Azure OpenAI Service

【ChatGPT】良いプロンプトに必要なものは?

はじめに 最近はChatGPTの普及もかなり進み、どのようにすれば動いてくれるかといったノウハウもだ […] -

Azure Machine Learning

【Azure ML】Databricks謹製の言語モデル”Dolly”を試してみた【Model Catalog】

はじめに 先日、Azure Machine Leaning のプレビュー機能として「モデルカタログ」 […] -

Azure OpenAI Service

Azure OpenAI Service

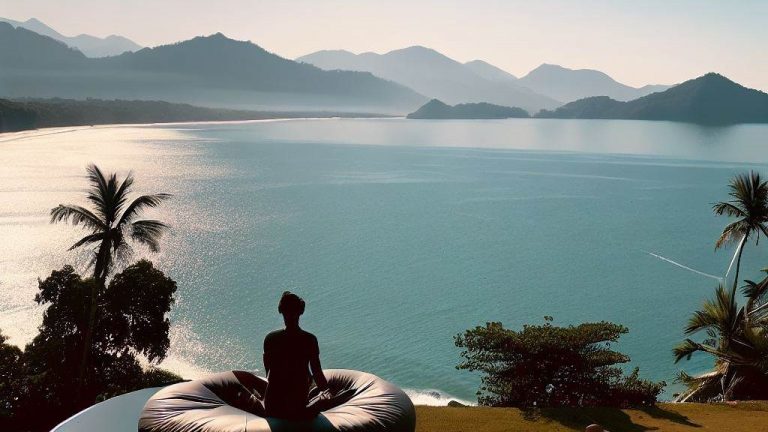

ChatGPTを活用した旅行計画:オーダーメイドな旅

旅行計画を立てる際、様々な目的や好みに合わせて最適なコースを提案する方法をお探しではありませんか?そ […] -

Azure OpenAI Service

Azure OpenAI Service

ChatGPTを使ったプロジェクト管理:タスク管理と進捗報告

プロジェクト管理においてタスク管理や進捗報告は、成功への道筋を明確にし、チーム全体の効率向上に寄与し […]