複数回に分けて、Azure Data Lakeの使い方についてご紹介します。

第二回はAzure Data LakeのAnalyticsを設定します。

前回の記事はこちらです。

Azure Data Lakeを触ってみた① Store編

Azure Data Lake Analytics

前回のおさらいとなりますが、2016年2月現在でAzure Data Lake は2つのサービスが提供されています。

・Azure Data Lake Store

・Azure Data Lake Analytics

主な役割としてはAzure Data Lake Storeがビッグデータを格納する為のリポジトリとなり、Azure Data Lake Analyticsで分散分析を行うというものになります。

前回はStoreの設定方法をご紹介したので、今回はAnalyticsの設定方法を紹介していきます。

Azure Data Lake Analyticsの設定

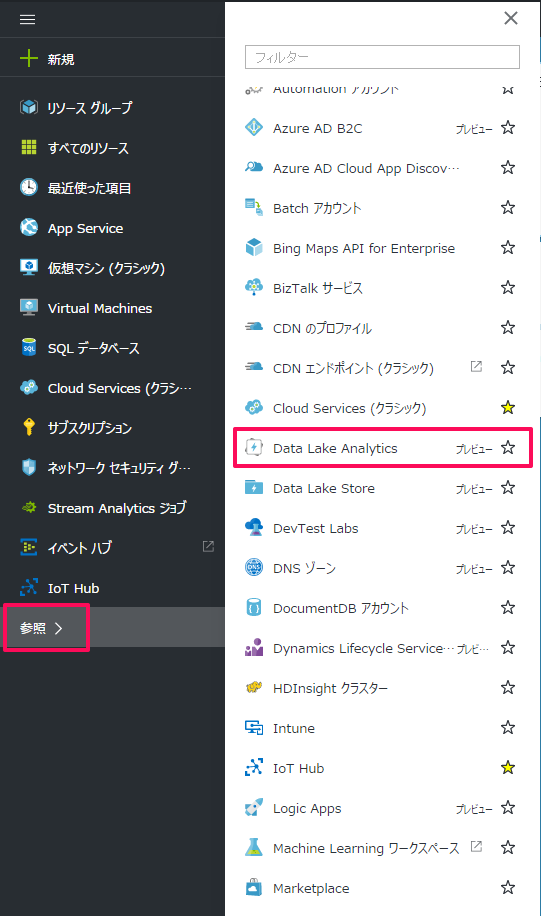

まずはAzureポータルにログインし、左のメニューから「Data Lake Analytics」を選択します。

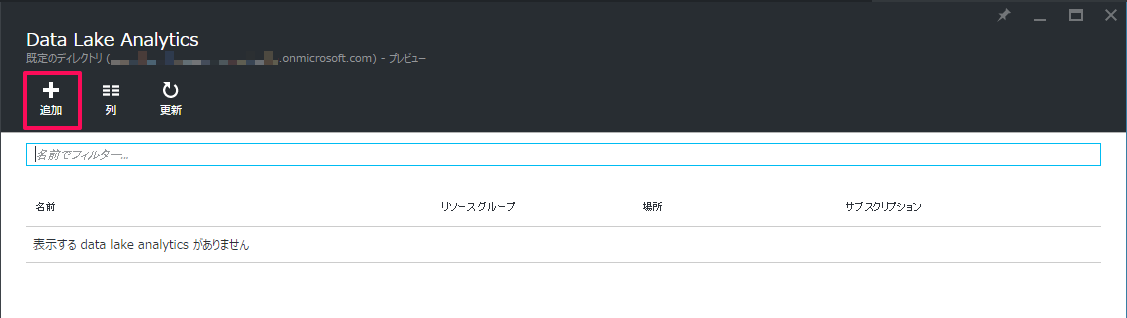

左上のボタンより「追加」をクリックします。

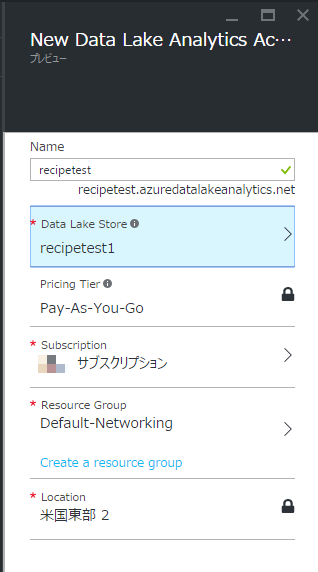

この画面でAnalyticsの設定を行います。

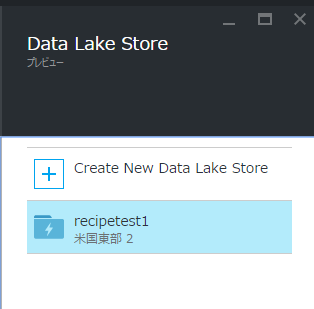

Analyticsを利用するにあたっては、データの格納先としてData Lake Storeを指定する必要がある為、既存のStoreを指定するか新規に作成する必要があります。

設定が完了し、Analyticsがデプロイされるのを待ちます。

クイックスタートを試す

今回はAzureから提供されているサンプル用のプログラムを実行します。

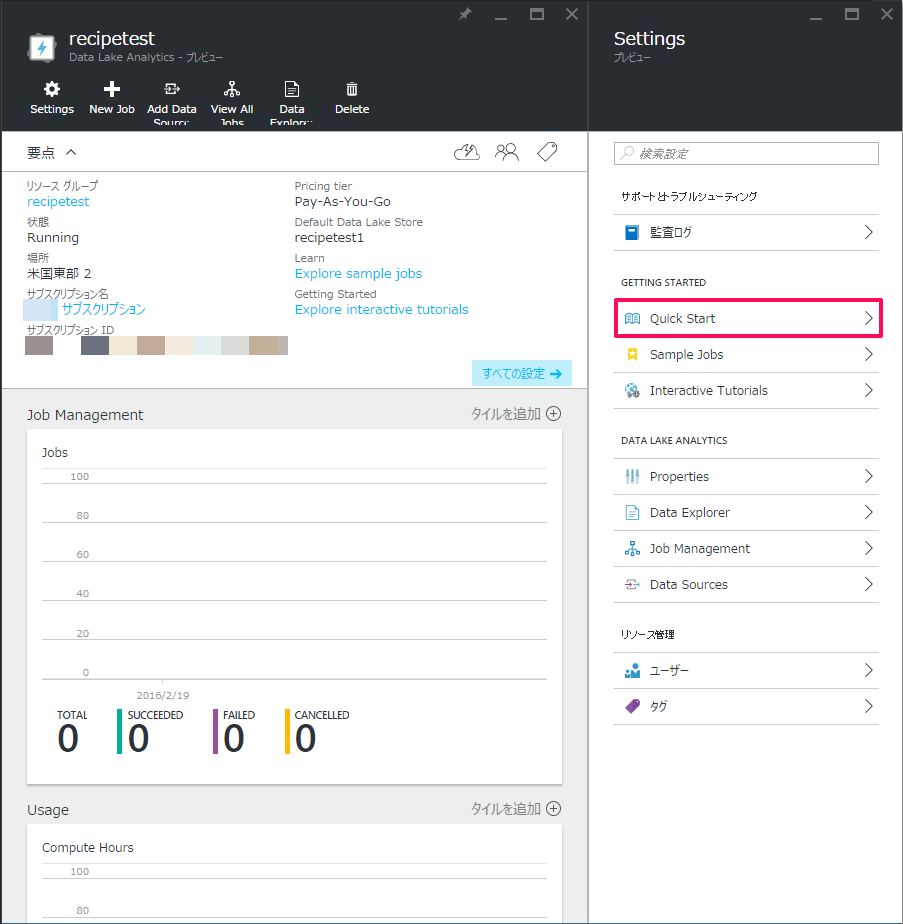

「Settings」の「Quick Start」をクリックします。

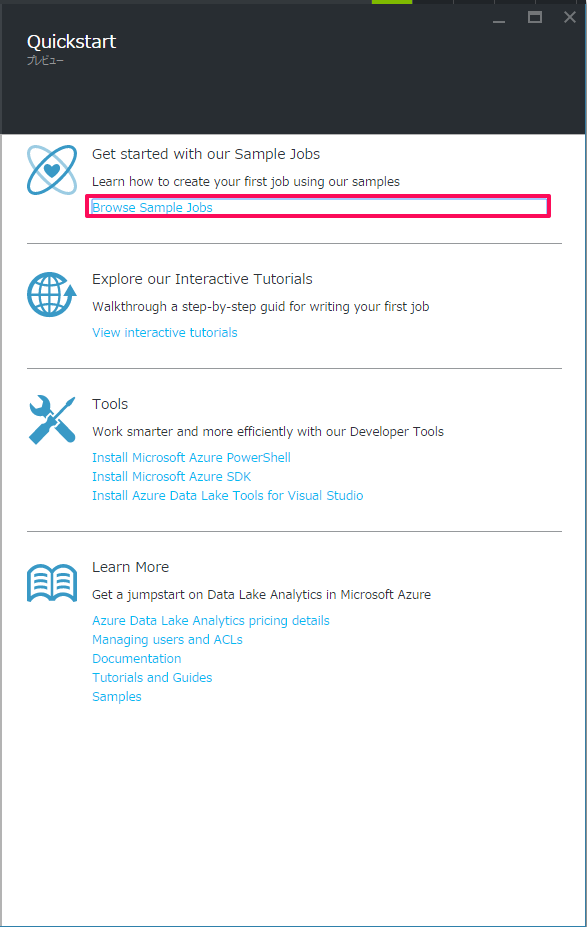

「Browse Sample Jobs」をクリックします。

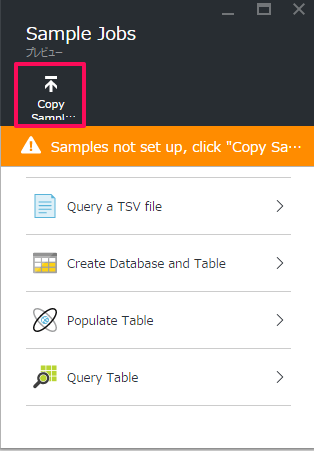

「Copy Sample」をクリックします。

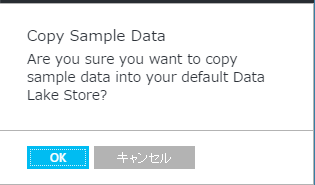

サンプルデータをStoreにコピーします。

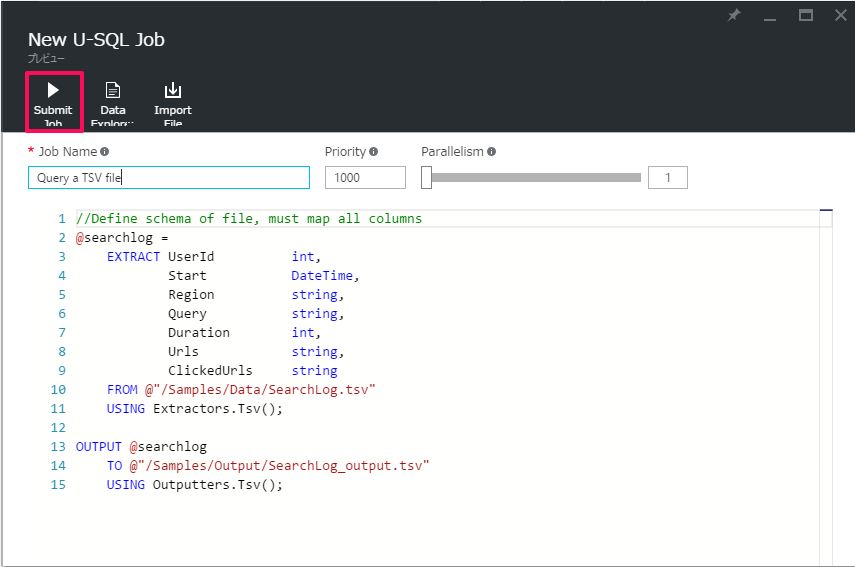

サンプルで使うU-SQLのjobが表示されます。

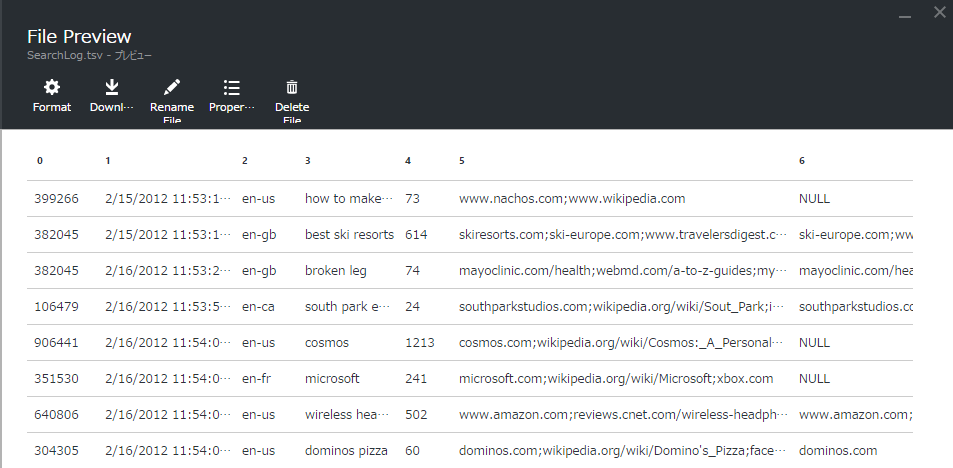

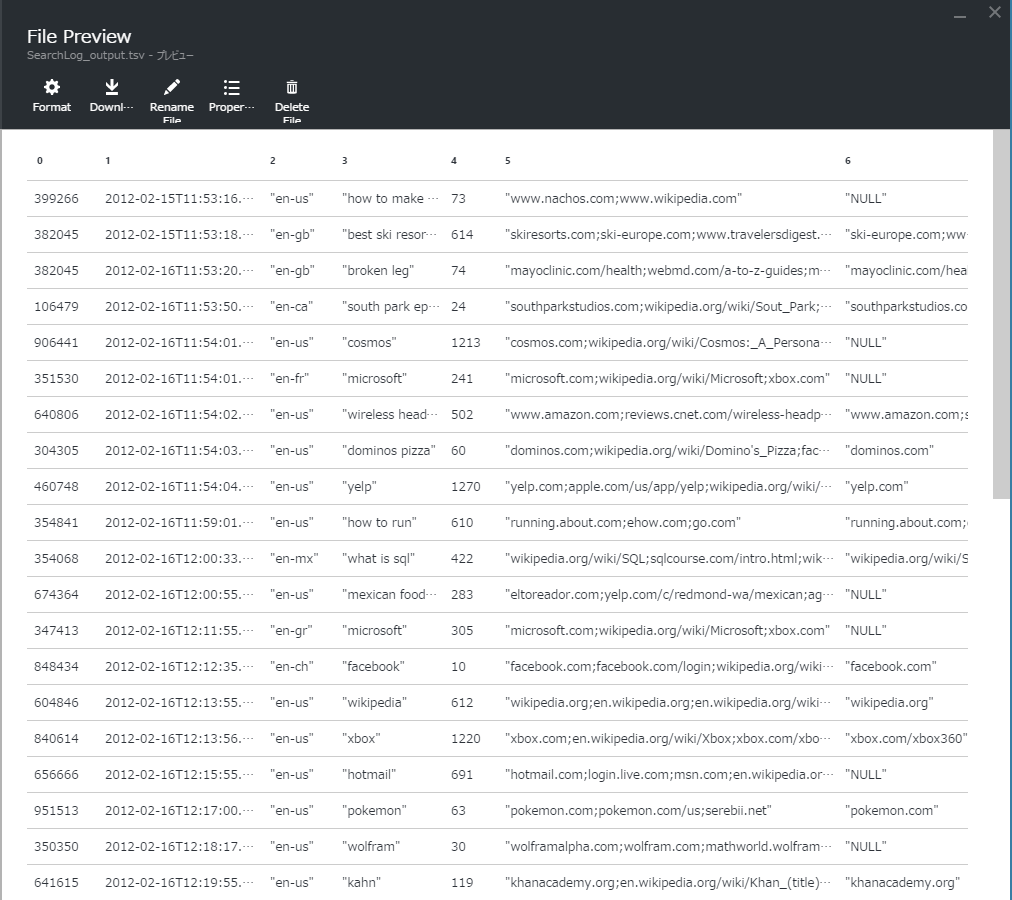

内容は「SearchLog.tsv」から指定のカラムを抜き出し、体系化してから「SerchLog_output.tsv」に出力するというものです。

「Submit Job」をクリックするとジョブが実行されます。

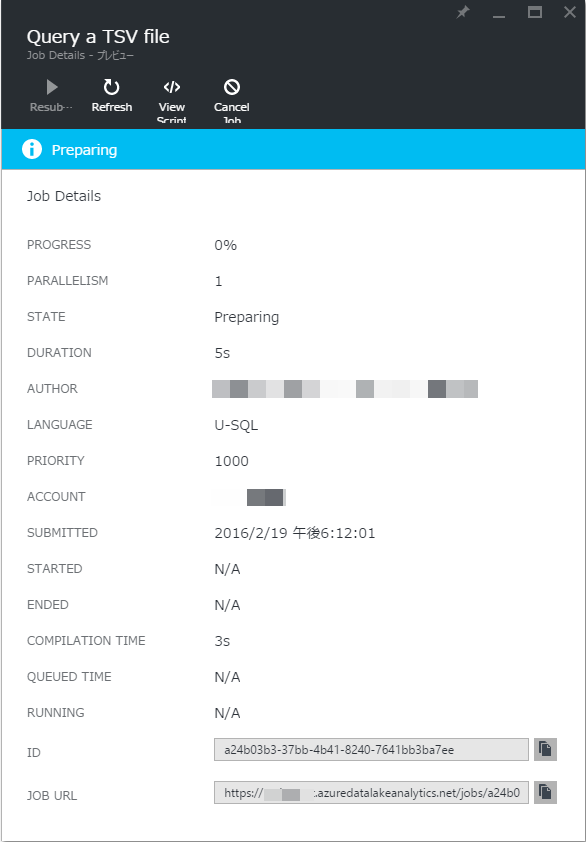

ジョブの実行中は「Preparing」と表示されます。これが「Succeeded」という表示に変わればジョブが完了しています。

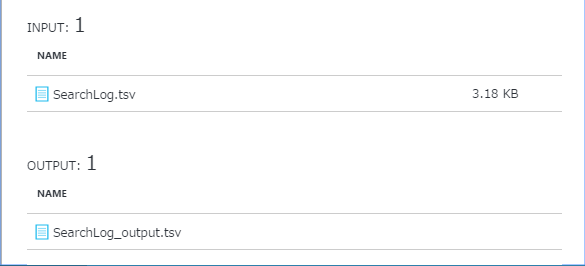

INPUT(元データ)とOUTPUT(出力データ)はそれぞれ「File Preview」で確認できます。

いかがでしたでしょうか。

前回と合わせてAzure Data Lakeをご紹介してきました。

Storeには形式・サイズを気にせずデータを置くことができ、Analyticsを使えば加工・分析を簡単に実行することができます。

従来のクラウドサービスとは一線を画すビッグデータサービスなので是非ご利用をご検討ください。

次回もお楽しみに!